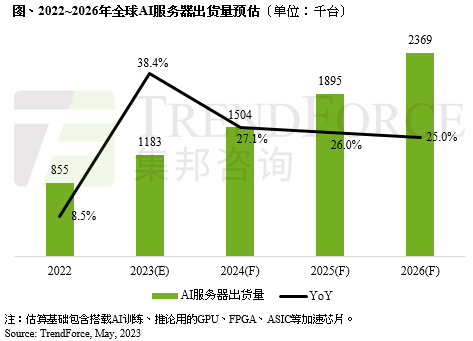

AI服务器及AI芯片需求同步看涨,TrendForce集邦咨询预估2023年AI服务器(包含搭载GPU、FPGA、ASIC等)出货量近120万台,年增38.4%,占整体服务器出货量近9%,至2026年将占15%,同步上修2022~2026年AI服务器出货量年复合成长率至22%。而AI芯片2023年出货量将成长46%。

TrendForce集邦咨询表示,NVIDIA GPU为AI服务器市场搭载主流,市占率约60~70%,其次为云端业者自主研发的ASIC芯片,市占率逾20%。

观察NVIDIA市占率高的主要原因有三:

其一,目前不论美系或中系云端服务业者(CSP),除了采购原有的NVIDIA的A100与A800外,下半年需求也将陆续导入H100与H800,尤其新机种H100与H800平均销售单价约为A100与A800的2~2.5倍,加上NVIDIA同时积极销售自家相关整机解决方案。

其二,高端GPU A100及H100的高获利模式也是关键,由于NVIDIA旗下产品在AI服务器市场已拥有主导权的优势,据TrendForce集邦咨询研究,H100本身的价差也依据买方采购规模,会产生近5,000美元的差异。

其三,下半年ChatBOT及AI运算风潮将持续渗透至各种专业领域(如云端/电商服务、智能制造、金融保险、智慧医疗及智能驾驶辅助等)的开发市场,同步带动每台搭配4~8张GPU的云端AI服务器,以及每台搭载2~4张GPU的边缘AI服务器应用需求渐增,预估今年搭载A100及H100的AI服务器出货量年增率逾5成。

此外,从高端GPU搭载的HBM来看,NVIDIA高端GPU H100、A100主采HBM2e、HBM3。以今年H100 GPU来说,搭载HBM3技术规格,其中传输速度也较HBM2e快,可提升整体AI服务器系统运算效能。

随着高端GPU如NVIDIA的A100、H100;AMD的MI200、MI300,以及Google自研的TPU等需求皆逐步提升,TrendForce集邦咨询预估2023年HBM需求量将年增58%,2024年有望再成长约30%。